Хотя большие языковые модели (LLM) дают возможность понимать и выполнять сложные задачи, малые модели не менее важны, поскольку их можно использовать локально на смартфонах и ПК. И Microsoft, похоже, разрабатывает впечатляющие малые языковые модели. Была представлена последняя модель Phi-3 Mini, которая обучается на 3,8 Б параметров.

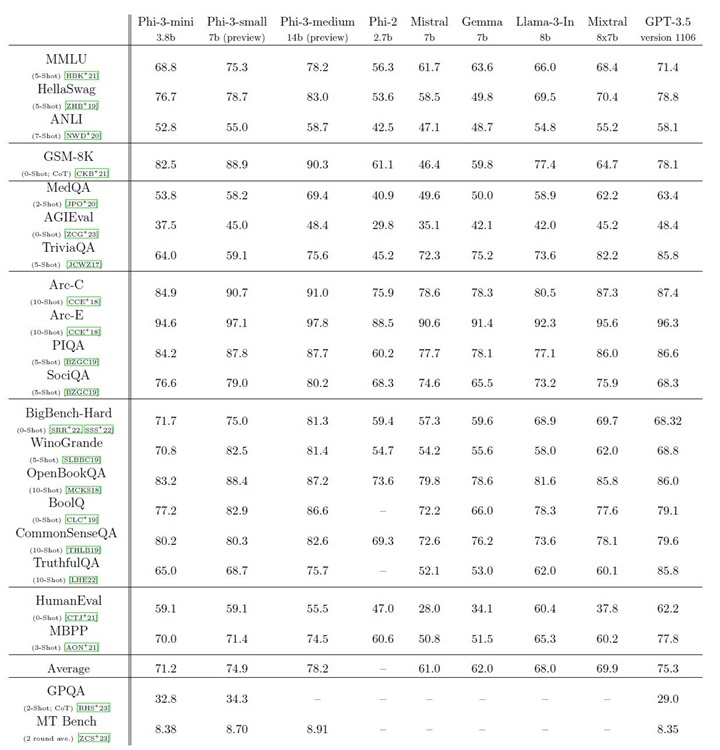

Есть еще две модели из семейства Phi-3: Phi-3 Small (7B) и Phi-3 Medium (14B), но они еще не выпущены. Что касается самой маленькой модели Phi-3 Mini, то в бенчмарке MMLU она показывает лучшие результаты, чем модели Meta Llama 3 8B, Google Gemma 7B и Mistral 7B. Более того, несмотря на небольшие размеры, он соответствует производительности Mixtral 8x7b, что весьма примечательно.

В HumanEval самая маленькая модель Phi-3 Mini работает гораздо лучше, чем Gemma 7B и Mistral 7B. Похоже, Microsoft приложила немало усилий, чтобы создать мощную маленькую модель для локальной работы на смартфонах и ПК. Самое приятное, что грядущие модели Phi-3 Small и Phi-3 Medium опережают модель GPT-3.5 от OpenAI, Mixtral 8x7b и Llama 3 8B. Как по мне, это очень впечатляет.

Microsoft утверждает, что Phi-3 достигает высокой производительности благодаря чистому набору данных, состоящему из сильно отфильтрованных веб-данных и синтетических данных. Далее модель проверяется на безопасность, вредность и устойчивость. Модель Phi-3, похоже, стала новым королем среди небольших моделей. Мне не терпится протестировать эту модель и проверить, превзойдет ли она модель Haiku от Anthropic, которая является самой маленькой моделью семейства Claude 3.

А вам не терпится протестировать новую модель Phi-3 Mini от Microsoft? Сообщите нам об этом в комментариях ниже. А пока вы можете узнать, как запустить модель Gemma от Google на своем ПК локально.

Оставить комментарий