Microsoft hat das Mini-Modell Phi-3 vorgestellt, das klein genug ist, um auf Handys zu laufen

Während große Sprachmodelle (LLMs) die Fähigkeit bieten, komplexe Aufgaben zu verstehen und auszuführen, sind kleine Modelle ebenso wichtig, da sie lokal auf Smartphones und PCs verwendet werden können. Und Microsoft scheint einige beeindruckende kleine Sprachmodelle zu entwickeln. Das neueste Modell Phi-3 Mini wurde vorgestellt, das auf 3,8 B Parameter lernt.

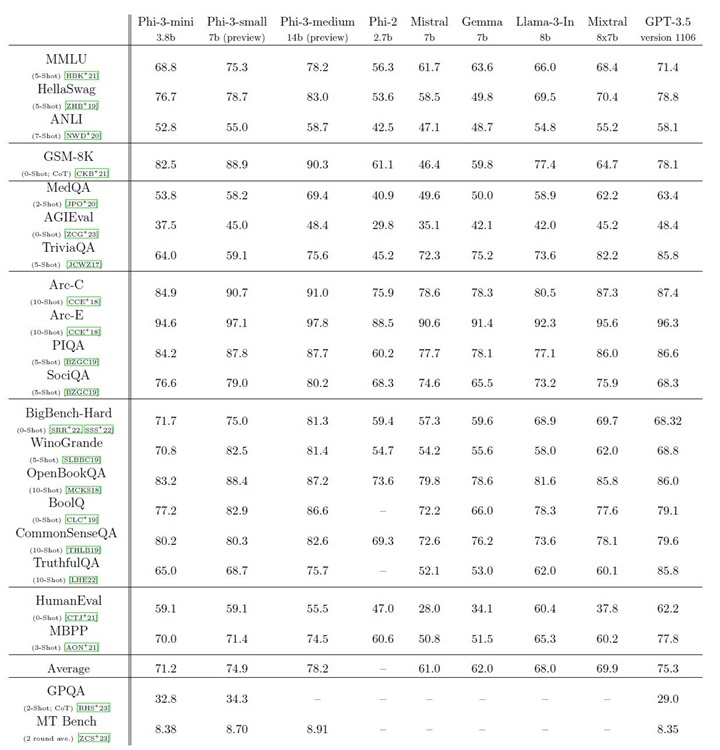

Es gibt zwei weitere Modelle der Phi-3-Familie, den Phi-3 Small (7B) und den Phi-3 Medium (14B), die aber noch nicht veröffentlicht wurden. Das kleinste Phi-3 Mini schneidet im MMLU-Benchmark besser ab als das Meta Llama 3 8B, Google Gemma 7B und Mistral 7B. Außerdem erreicht er trotz seiner geringen Größe die Leistung des Mixtral 8x7b, was recht bemerkenswert ist.

Bei HumanEval schneidet das kleinste Phi-3 Mini-Modell viel besser ab als das Gemma 7B und das Mistral 7B. Es sieht so aus, als hätte sich Microsoft viel Mühe gegeben, ein leistungsstarkes kleines Modell für den lokalen Betrieb auf Smartphones und PCs zu entwickeln. Das Beste daran ist, dass die kommenden Modelle Phi-3 Small und Phi-3 Medium den Modellen GPT-3.5, Mixtral 8x7b und Llama 3 8B von OpenAI voraus sind. Das klingt für mich ziemlich beeindruckend.

Microsoft behauptet, dass Phi-3 eine hohe Leistung mit einem sauberen Datensatz erreicht, der aus stark gefilterten Webdaten und synthetischen Daten besteht. Das Modell wurde außerdem auf Sicherheit, Schädlichkeit und Robustheit geprüft. Das Phi-3-Modell scheint der neue König unter den kleinen Modellen zu sein. Ich kann es kaum erwarten, dieses Modell zu testen und zu sehen, ob es das Haiku von Anthropic, das kleinste Modell der Claude-3-Familie, übertrifft.

Und freuen Sie sich darauf, das neue Phi-3 Mini-Modell von Microsoft zu testen? Lassen Sie es uns in den Kommentaren unten wissen. In der Zwischenzeit erfahren Sie, wie Sie das Gemma-Modell von Google lokal auf Ihrem PC ausführen können.

Mark Otto